Was ist A/B-Testing? Leitfaden, Tools, Beispiele

Appinio Research · 11.09.2024 · 44min Lesezeit

Inhalt

Möchten Sie Ihre digitalen Strategien in datengesteuerte Erfolge umwandeln? In der dynamischen Online-Landschaft von heute ist es eine ständige Herausforderung, eine optimale Nutzerbindung, Konversionen und Leistung zu erreichen.

Dieser Leitfaden ist Ihr Kompass, der Sie durch das komplizierte Gebiet der datengesteuerten Entscheidungsfindung führt. Tauchen Sie ein in die Welt der A/B-Tests und entdecken Sie die Möglichkeiten, Hypothesen zu überprüfen, das Nutzererlebnis zu verbessern und letztendlich den Erfolg im digitalen Bereich zu steigern.

Was ist A/B-Testing?

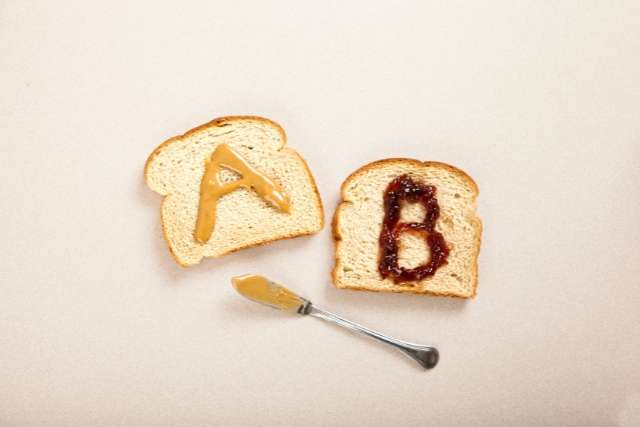

A/B-Testing, auch bekannt als Split-Testing oder Bucket-Testing, ist eine Methode zur Bewertung und zum Vergleich zweier Versionen einer Webseite, einer E-Mail-Kampagne, einer App-Oberfläche oder eines anderen digitalen Assets. Dabei werden zwei Varianten, Version A (die Kontrollgruppe) und Version B (die Versuchsgruppe), verschiedenen Nutzergruppen gleichzeitig präsentiert. Durch die Messung der Benutzerinteraktionen und des Benutzerverhaltens hilft A/B-Testing Unternehmen und Organisationen, datengestützte Entscheidungen zu treffen, um ihre digitalen Ressourcen für eine bessere Leistung, Benutzerbindung und Konversionen zu optimieren.

Hauptaspekte von A/B-Tests

- Randomisierung: Die Benutzer werden nach dem Zufallsprinzip entweder der Version A oder der Version B zugewiesen, um Verzerrungen auszuschließen und einen fairen Vergleich zu gewährleisten.

- Statistische Signifikanz: A/B-Tests verwenden statistische Analysen, um festzustellen, ob die Unterschiede zwischen den Varianten statistisch signifikant sind oder einfach nur dem Zufall geschuldet sind.

- Schlüsselmetriken: Die Tests basieren auf vordefinierten Schlüsselmetriken oder -zielen, wie z. B. Click-Through-Raten, Konversionsraten, Öffnungsraten oder Einnahmen pro Besucher.

- Iterativer Prozess: A/B-Tests sind ein iterativer Prozess, der es Unternehmen ermöglicht, ihre digitalen Ressourcen im Laufe der Zeit kontinuierlich zu verfeinern und zu verbessern.

Bedeutung von A/B-Tests

A/B-Tests spielen eine wichtige Rolle bei datengesteuerten Entscheidungsfindungs- und Optimierungsstrategien für Unternehmen und Organisationen. Hier erfahren Sie, warum A/B-Tests so wichtig sind:

- Evidenzbasierte Entscheidungsfindung: A/B-Tests liefern konkrete Daten und Erkenntnisse, die es Unternehmen ermöglichen, Entscheidungen auf der Grundlage des tatsächlichen Nutzerverhaltens und nicht auf der Grundlage von Annahmen oder Meinungen zu treffen.

- Optimierung der Benutzererfahrung: Es hilft bei der Verbesserung des Nutzererlebnisses, indem es Änderungen identifiziert, die bei der Zielgruppe besser ankommen, was zu mehr Engagement und Zufriedenheit führt.

- Maximierung der Konversionen: A/B-Tests helfen dabei, herauszufinden, welche Elemente oder Strategien zu höheren Konversionsraten führen, z. B. zu mehr Käufen, Anmeldungen oder Klicks, was letztlich den Umsatz und den ROI steigert.

- Risikominimierung: Durch das Testen von Änderungen an einer Untergruppe von Benutzern können Unternehmen potenzielle Risiken einschätzen und sicherstellen, dass sich die Änderungen nicht negativ auf die gesamte Benutzerbasis auswirken.

- Kontinuierliche Verbesserung: A/B-Tests fördern eine Kultur der kontinuierlichen Verbesserung, die es Unternehmen ermöglicht, ihre digitalen Assets iterativ zu verfeinern und der Konkurrenz voraus zu sein.

- Kosteneffizienz: Unternehmen können ihre Ressourcen effektiv einsetzen, indem sie in Änderungen investieren, die nachweislich positive Ergebnisse bringen, und so kostspielige Fehltritte vermeiden.

- Personalisierung: Mithilfe von A/B-Tests lassen sich Inhalte und Erlebnisse für verschiedene Nutzersegmente personalisieren, was die Relevanz und das Engagement erhöht.

- Verbesserung von Marketing-Kampagnen: Im Marketing helfen A/B-Tests bei der Feinabstimmung von E-Mail-Kampagnen, Anzeigentexten, Landing Pages und anderen Assets, um die Effektivität und den ROI zu maximieren.

- Anpassung an Nutzertrends: Unternehmen können sich an veränderte Nutzerpräferenzen und Trends anpassen, indem sie ihre digitale Präsenz kontinuierlich testen und optimieren.

- Validierung von Hypothesen: A/B-Tests ermöglichen es Unternehmen, Hypothesen und Ideen schnell zu validieren und sicherzustellen, dass Änderungen durch empirische Beweise gestützt werden.

A/B-Tests sind ein leistungsfähiges Tool, das Unternehmen und Organisationen in die Lage versetzt, fundierte Entscheidungen zu treffen, die Nutzererfahrung zu verbessern und bessere Ergebnisse auf datengestützte und kosteneffiziente Weise zu erzielen. Es handelt sich um eine grundlegende Praxis in der Welt der digitalen Optimierung und des Marketings.

Wie plant man einen A/B-Test?

Bevor Sie mit A/B-Tests beginnen, ist es wichtig, einen gut durchdachten Plan zu haben. Eine korrekte Planung bildet die Grundlage für ein erfolgreiches Experiment und stellt sicher, dass Sie aussagekräftige Erkenntnisse gewinnen. Gehen wir näher auf die einzelnen Aspekte der Planung Ihres A/B-Tests ein.

1. Definieren Sie klare Ziele

Wenn Sie klare Ziele für Ihren A/B-Test festlegen, sollten Sie sich überlegen, welche spezifischen Ziele Sie erreichen möchten. Ihre Ziele sollten sein:

- Spezifisch: Geben Sie klar und deutlich an, was Sie erreichen wollen. Anstelle eines vagen Ziels wie "Verbesserung der Website-Performance" könnten Sie z. B. angeben: "Erhöhung der Klickrate auf der Produktseite um 15 %".

- Messbar: Legen Sie Metriken fest, mit denen Sie den Erfolg messen können. Im obigen Beispiel ist die messbare Kennzahl die Klickrate.

- Auf die Ziele abgestimmt: Stellen Sie sicher, dass Ihre Ziele mit Ihren allgemeinen Geschäfts- oder Projektzielen übereinstimmen. Wenn Ihr Hauptziel darin besteht, den Umsatz zu steigern, sollten Sie sich auf Ziele konzentrieren, die zu diesem Ziel beitragen.

- Zeitgebunden: Legen Sie einen Zeitrahmen für die Erreichung Ihrer Ziele fest. Dies erhöht die Dringlichkeit und hilft Ihnen zu bestimmen, wann der Test als abgeschlossen gilt.

- Realistisch: Stellen Sie sicher, dass Ihre Ziele im Rahmen Ihres Tests erreichbar sind. Wenn Sie zu ehrgeizige Ziele setzen, kann dies zu unrealistischen Erwartungen führen.

Wenn Sie beispielsweise eine E-Commerce-Website betreiben, könnten Ihre A/B-Testziele die Erhöhung der Konversionsrate, die Verringerung der Zahl der abgebrochenen Warenkörbe oder die Verbesserung der Interaktion mit der Produktseite umfassen. Klare Ziele leiten den gesamten Testprozess und stellen sicher, dass Sie ein bestimmtes Ziel vor Augen haben.

2. Identifizieren Sie Schlüsselmetriken

Die Ermittlung der richtigen Schlüsselkennzahlen ist entscheidend für die Erfolgsmessung Ihres A/B-Tests. Die Auswahl der Metriken sollte mit Ihren Zielen übereinstimmen und wertvolle Einblicke in das Nutzerverhalten liefern. Hier sind einige gängige Kennzahlen, die Sie berücksichtigen sollten:

- Konversionsrate: Dies ist eine der grundlegendsten Metriken. Sie misst den Prozentsatz der Besucher, die die gewünschte Aktion durchführen, wie z. B. einen Kauf tätigen oder sich anmelden.

- Click-Through-Rate (CTR): Die CTR misst die Effektivität von Links oder Aufrufen zum Handeln. Sie ist besonders wichtig für E-Mail-Kampagnen und Landing Pages.

- Umsatz pro Besucher (Revenue per Visitor, RPV): Wenn Ihr Ziel einkommensorientiert ist, hilft der RPV dabei festzustellen, wie viel jeder Besucher zu Ihren Einnahmen beiträgt.

- Absprungrate: Die Absprungrate gibt den Prozentsatz der Besucher an, die Ihre Website verlassen, nachdem sie nur eine Seite angesehen haben. Eine Verringerung der Absprungrate führt häufig zu einer verbesserten Nutzerbindung.

- Sitzungsdauer: Diese Kennzahl gibt an, wie lange Besucher auf Ihrer Website verweilen. Längere Sitzungen weisen oft auf engagiertere Benutzer hin.

- Abbruchrate des Warenkorbs: Bei E-Commerce-Websites misst diese Kennzahl den Prozentsatz der Nutzer, die Produkte in ihren Warenkorb legen, den Kauf aber nicht abschließen.

Die Auswahl der Schlüsselkennzahlen hängt von Ihren spezifischen Zielen ab. Wenn Sie beispielsweise das Engagement erhöhen möchten, können Sie sich auf Kennzahlen wie Sitzungsdauer und Seitenaufrufe konzentrieren. Wenn Sie Ihren Umsatz steigern wollen, sind die Konversionsrate und der RPV entscheidend.

3. Wählen Sie die Testvariable

Die Testvariable, auch als "Behandlung" oder "Variante" bezeichnet, ist das Element oder die Elemente, die Sie testen möchten. Dazu kann jeder Aspekt Ihrer digitalen Inhalte gehören, wie z. B.:

- Überschriften: Testen verschiedener Schlagzeilenvarianten, um zu sehen, welche mehr Aufmerksamkeit erregt.

- Bilder: Vergleich der Auswirkungen verschiedener Fotos oder Grafiken auf das Engagement der Nutzer.

- Call-to-Action (CTA)-Schaltflächen: Experimentieren mit verschiedenen Texten, Farben oder Platzierungen von CTA-Schaltflächen.

- Seitenlayout: Testen verschiedener Seitenlayouts, Navigationsmenüs oder der Organisation von Inhalten.

- Produktbeschreibungen: Evaluierung der Effektivität verschiedener Produktbeschreibungen zur Steigerung der Konversionen.

Bei der Auswahl der Testvariablen ist es wichtig, sich jeweils auf ein Element zu konzentrieren, um die Auswirkungen der Änderung zu isolieren. Das gleichzeitige Testen mehrerer Variablen kann zu zweideutigen Ergebnissen führen. Vergewissern Sie sich, dass die von Ihnen gewählte Variable in direktem Zusammenhang mit Ihren Zielen und Metriken steht.

4. Stichprobengröße bestimmen

Die Bestimmung der richtigen Stichprobengröße ist entscheidend für die statistische Aussagekraft Ihres A/B-Tests. Eine zu kleine Stichprobe kann zu unzuverlässigen Ergebnissen führen, während eine zu große Stichprobe ressourcen- und zeitaufwändig sein kann. Im Folgenden erfahren Sie, wie Sie eine angemessene Stichprobengröße berechnen:

- Statistisches Signifikanzniveau: Entscheiden Sie sich für das statistische Signifikanzniveau, das Sie erreichen möchten. Übliche Werte sind 95 % und 99 %, die angeben, wie viel Vertrauen Sie in die Ergebnisse haben.

- Minimaler nachweisbarer Effekt (MDE): Bestimmen Sie den kleinsten signifikanten Unterschied, den Sie nachweisen wollen. Dieser Wert hängt oft von Ihren Zielen ab. Wenn Sie beispielsweise eine Steigerung der Konversionsrate um 10 % feststellen möchten, beträgt der MDE-Wert 10 %.

- Grundlegende Konversionsrate: Kennen Sie die aktuelle Konversionsrate des Elements, das Sie testen. Diese dient als Basiswert.

- Variabilität: Verstehen Sie die Schwankungen oder Unsicherheiten in Ihren Daten.

Sobald Sie diese Parameter kennen, können Sie mithilfe von Online-Rechnern für den Stichprobenumfang oder statistischer Software den für Ihren Test erforderlichen Stichprobenumfang ermitteln. Ein größerer Stichprobenumfang erhöht die Wahrscheinlichkeit, dass kleine, aber aussagekräftige Veränderungen erkannt werden, während ein kleinerer Stichprobenumfang zwar effizienter ist, aber möglicherweise subtile Verbesserungen verpasst.

Die richtige Planung Ihres A/B-Tests schafft die Voraussetzungen für ein erfolgreiches Experiment. Klare Ziele, gut gewählte Messgrößen, eine sorgfältig ausgewählte Testvariable und eine angemessene Stichprobengröße gewährleisten, dass Ihr Test sowohl informativ als auch umsetzbar ist.

Wie richtet man einen A/B-Test ein?

Sobald Sie einen klaren Plan haben, ist es an der Zeit, Ihren A/B-Test effektiv einzurichten. Diese Phase umfasst die Erstellung der Testvarianten, die Sicherstellung unvoreingenommener Tests durch Randomisierung und die Implementierung robuster Tracking- und Analysemethoden zur Erfassung wertvoller Daten.

Sobald Sie einen klaren Plan haben, ist es an der Zeit, Ihren A/B-Test effektiv einzurichten. Diese Phase umfasst die Erstellung der Testvarianten, die Sicherstellung unvoreingenommener Tests durch Randomisierung und die Implementierung robuster Tracking- und Analysemethoden zur Erfassung wertvoller Daten.

1. Variationen erstellen (A und B)

Die Erstellung der Varianten A und B ist das Herzstück des A/B-Tests. Hier erfahren Sie, wie Sie dies effektiv tun können:

- Identifizieren Sie das zu testende Element: Greifen Sie auf die Testvariable zurück, die Sie in der Planungsphase ausgewählt haben. Dies kann eine Überschrift, ein Bild, eine CTA-Schaltfläche, ein Seitenlayout oder ein anderes Element sein.

- Entwerfen Sie die Variationen: Erstellen Sie zwei verschiedene Versionen des Elements. Version A (die Kontrollgruppe) sollte unverändert bleiben und als Grundlinie dienen. Version B (die Versuchsgruppe) sollte die spezifischen Änderungen enthalten, die Sie testen möchten.

Beispiel: Wenn Sie die Farbe einer CTA-Schaltfläche testen, könnte Version A eine grüne Schaltfläche enthalten, während Version B eine rote Schaltfläche enthält. - Bewahren Sie Konsistenz: Stellen Sie sicher, dass alle anderen Elemente auf der Seite zwischen den beiden Varianten konsistent bleiben. Das bedeutet, dass Sie denselben Text, dieselben Bilder und dasselbe Layout verwenden, mit Ausnahme des Elements, das Sie testen.

- Testen Sie jeweils nur eine Variable: Es ist wichtig, dass Sie die Auswirkungen der zu testenden Änderung isolieren. Wenn Sie in Version B mehrere Änderungen vornehmen, können Sie nicht feststellen, welche davon die Ergebnisse beeinflusst haben.

- Erstellen Sie mehrere Versionen: Wenn Ihr Test mehrere Elemente umfasst (z. B. sowohl die Überschrift als auch die CTA-Schaltfläche), erstellen Sie Variationen für jede Elementkombination. Auf diese Weise können Sie die individuellen und kombinierten Auswirkungen der Elemente testen.

2. Randomisierung und Kontrollgruppen

Die Randomisierung und die Verwendung von Kontrollgruppen sind entscheidend für die Gültigkeit Ihres A/B-Tests:

- Zufällige Zuweisung: Die Besucher sollten nach dem Zufallsprinzip entweder der Version A oder der Version B zugewiesen werden. Diese Randomisierung hilft, Verzerrungen zu vermeiden und stellt sicher, dass die Gruppen vergleichbar sind.

Beispiel: Auf einer E-Commerce-Website wird den eingehenden Besuchern nach dem Zufallsprinzip entweder Version A oder Version B angezeigt, so dass jede Version die gleiche Chance hat, gesehen zu werden. - Kontrollgruppe: Die Kontrollgruppe (Version A) ist wichtig, weil sie eine Basis für den Vergleich bietet. Sie zeigt, wie sich Ihre Webseite oder Ihr Inhalt ohne Änderungen verhält.

- Vermeidung von Selektionsverzerrungen: Achten Sie darauf, dass die Methode, mit der Sie die Besucher den Gruppen zuordnen, nicht zu Verzerrungen führt. Ordnen Sie zum Beispiel nicht alle neuen Besucher einer Version zu und wiederkehrende Besucher einer anderen.

- Ausgeglichener Verkehr: Achten Sie auf eine annähernd gleichmäßige Verteilung der Besucherzahlen auf die beiden Versionen, um sicherzustellen, dass die Ergebnisse repräsentativ für Ihr gesamtes Publikum sind.

3. Tracking und Analyse implementieren

Genaue Nachverfolgung und solide Analysen sind für die Gewinnung von Erkenntnissen aus Ihrem A/B-Test unerlässlich:

- Tracking-Tools: Implementieren Sie Tracking-Tools wie Google Analytics, Mixpanel oder spezielle A/B-Testplattformen, um Daten über das Nutzerverhalten, Konversionen und wichtige Kennzahlen zu sammeln.

- Ereignisverfolgung: Richten Sie eine Ereignisverfolgung ein, um bestimmte Nutzerinteraktionen im Zusammenhang mit Ihren Zielen zu überwachen. Dazu kann die Verfolgung von Klicks auf CTA-Schaltflächen, Formularübermittlungen oder Produktkäufen gehören.

- Zielkonfiguration: Definieren Sie klare Ziele innerhalb Ihrer Analyseplattform, um Konversionen und andere relevante Aktionen genau zu messen.

- Datenkonsistenz: Stellen Sie sicher, dass Ihr Tracking-Code in beiden Varianten korrekt implementiert ist, um Datendiskrepanzen zu vermeiden.

- Überwachung in Echtzeit: Überwachen Sie den Test in Echtzeit, um alle Probleme oder Anomalien zu erkennen, die während des Testzeitraums auftreten können.

- A/B-Test-Software: Ziehen Sie den Einsatz einer speziellen A/B-Testing-Software in Betracht, die Randomisierungs-, Nachverfolgungs- und Berichtsfunktionen bietet. Diese Tools können den Prozess vereinfachen und bieten erweiterte Analysefunktionen.

- Datenschutz und Compliance: Halten Sie sich bei der Erfassung und Verarbeitung von Nutzerdaten an Datenschutzbestimmungen wie GDPR oder CCPA.

Wenn Sie Ihre A/B-Tests mit gut durchdachten Variationen, angemessener Randomisierung und zuverlässiger Nachverfolgung und Analyse einrichten, stellen Sie sicher, dass Sie die Auswirkungen Ihrer Änderungen genau messen und aussagekräftige Schlussfolgerungen aus den Ergebnissen ziehen können.

Wie führt man einen A/B-Test durch?

Nachdem Sie nun Ihren A/B-Test mit klaren Zielen, Variationen und Tracking eingerichtet haben, ist es an der Zeit, den Test durchzuführen. Wir führen Sie durch den Testzeitraum, die Überwachung und die Datenerfassung und zeigen Ihnen, wie Sie mit externen Faktoren umgehen, die Ihre Ergebnisse beeinflussen könnten.

1. Durchführung des Testzeitraums

Die Durchführung des Testzeitraums ist ein entscheidender Schritt bei A/B-Tests, da er die Dauer der Datenerfassung bestimmt. Im Folgenden erfahren Sie, wie Sie diese Phase effektiv gestalten können:

- Definieren Sie eine Testdauer: Entscheiden Sie, wie lange Sie den Test durchführen wollen. Es ist wichtig, ein Gleichgewicht zwischen dem Sammeln ausreichender Daten für die statistische Signifikanz und der Minimierung der Zeit, die für fundierte Entscheidungen benötigt wird, herzustellen.

- Statistische Signifikanz: Überwachen Sie den Fortschritt Ihres Tests und behalten Sie die statistische Signifikanz Ihrer Ergebnisse im Auge. Möglicherweise müssen Sie die Testdauer verlängern, wenn die Signifikanz nicht erreicht wurde.

- Berücksichtigen Sie das Besucherverhalten: Berücksichtigen Sie die Verhaltensmuster der Besucher, z. B. tägliche oder wöchentliche Zyklen. Stellen Sie sicher, dass Ihre Testdauer eine repräsentative Stichprobe Ihrer Zielgruppe abdeckt.

- Vermeiden Sie saisonale Einflüsse: Wenn Ihre Website oder App saisonale Schwankungen im Besucheraufkommen aufweist, sollten Sie den Test für einen vollständigen Zyklus durchführen, um diese Schwankungen zu berücksichtigen.

- Verkehr gleichmäßig aufteilen: Achten Sie darauf, dass der Verkehr während des gesamten Testzeitraums gleichmäßig auf die beiden Varianten verteilt ist. Jedes Ungleichgewicht kann Ihre Ergebnisse verfälschen.

- Änderungen begrenzen: Nehmen Sie während des Testzeitraums keine Änderungen an den Testvarianten vor, da dies die Ergebnisse verfälschen kann.

2. Überwachung und Datenerhebung

Eine wirksame Überwachung und Datenerfassung sind unerlässlich, um die Integrität Ihres A/B-Tests zu gewährleisten:

- Überprüfen Sie regelmäßig die Daten: Überwachen Sie Ihren Test täglich oder in regelmäßigen Abständen, um sicherzustellen, dass die Datenerfassung korrekt funktioniert. Achten Sie auf Anomalien oder technische Probleme.

- Ereignisverfolgung: Achten Sie besonders auf die Ereignisse, die Sie verfolgen, wie z. B. Klicks oder Konversionen. Vergewissern Sie sich, dass diese Ereignisse genau aufgezeichnet werden.

- Traffic-Volumen: Behalten Sie das Traffic-Volumen für jede Variante im Auge. Erhebliche Abweichungen können die Zuverlässigkeit Ihrer Ergebnisse beeinträchtigen.

- Engagement-Metriken: Überwachen Sie Engagement-Metriken wie Absprungrate, Sitzungsdauer und Seitenaufrufe, um zu verstehen, wie die Nutzer mit Ihren Variationen interagieren.

- Zielkonversionen: Verfolgen Sie den Fortschritt Ihrer Ziele und Konversionen während des gesamten Testzeitraums, um zu beurteilen, ob Ihre Ziele erreicht werden.

- Segmentierung: Ziehen Sie in Erwägung, Ihre Daten nach demografischen Merkmalen oder Verhalten der Nutzer zu segmentieren, um tiefere Einblicke in die Reaktion verschiedener Gruppen auf die Variationen zu gewinnen.

- Datensicherung: Stellen Sie sicher, dass Sie über Sicherungskopien Ihrer Daten verfügen, für den Fall, dass während des Tests technische Probleme auftreten oder Daten verloren gehen.

3. Umgang mit externen Faktoren

Externe Faktoren können die Ergebnisse Ihrer A/B-Tests beeinflussen, und es ist wichtig, diese zu berücksichtigen:

- Saisonabhängigkeit: Wenn Ihr Unternehmen saisonalen Schwankungen unterliegt, sollten Sie sich darüber im Klaren sein, dass sich diese auf Ihre Ergebnisse auswirken können. Nehmen Sie bei Bedarf saisonale Anpassungen vor oder erwägen Sie, den Test über mehrere Saisons hinweg durchzuführen.

- Marketing-Kampagnen: Achten Sie auf laufende Marketingkampagnen oder Werbeaktionen, die das Nutzerverhalten beeinflussen können. Idealerweise führen Sie die Tests in Zeiten durch, in denen Ihre Marketingaktivitäten relativ stabil sind.

- Technische Pannen: Kümmern Sie sich umgehend um technische Probleme, um sicherzustellen, dass sie Ihre Ergebnisse nicht verfälschen. Wenn zum Beispiel Ihre Website nicht funktioniert, kann dies die Datenerfassung beeinträchtigen.

- Externe Ereignisse: Berücksichtigen Sie externe Ereignisse, die das Nutzerverhalten beeinflussen könnten, z. B. Branchennachrichten, Feiertage oder globale Ereignisse. Auch wenn Sie diese Faktoren nicht kontrollieren können, ist ihre Kenntnis für die Interpretation Ihrer Ergebnisse entscheidend.

- A/B-Test-Dauer: Stellen Sie sicher, dass die Dauer Ihres A/B-Tests lang genug ist, um externe Faktoren zu berücksichtigen. Längere Tests können dazu beitragen, die Auswirkungen kurzfristiger Störungen auszugleichen.

- Dokumentation: Dokumentieren Sie alle wichtigen externen Ereignisse oder Anomalien, die während des Testzeitraums aufgetreten sind. Diese Informationen können bei der Analyse Ihrer Ergebnisse von großem Nutzen sein.

Ein effektives Management des Testzeitraums, die Überwachung der Datenerfassung und die Berücksichtigung externer Faktoren sind entscheidend, um zuverlässige Ergebnisse aus Ihrem A/B-Test zu erhalten.

Wie analysiert man die Ergebnisse von A/B-Tests?

Sobald Sie die Testphase Ihres A/B-Tests abgeschlossen haben, ist es an der Zeit, die Ergebnisse zu analysieren. Bei diesem wichtigen Schritt geht es darum, die statistische Signifikanz Ihrer Ergebnisse zu bewerten, die Daten zu interpretieren und sinnvolle Schlussfolgerungen zu ziehen.

Statistische Signifikanz

Die statistische Signifikanz ist ein grundlegendes Konzept bei A/B-Tests. Mit ihrer Hilfe können Sie feststellen, ob die Unterschiede zwischen den Varianten A und B aussagekräftig sind oder ob es sich lediglich um einen Zufall handelt. Im Folgenden erfahren Sie, wie Sie die statistische Signifikanz beurteilen können:

- Wählen Sie ein Signifikanzniveau: Entscheiden Sie sich für ein Signifikanzniveau, das oft als Alpha (α) bezeichnet wird und die Wahrscheinlichkeit eines Fehlers vom Typ I darstellt (fälschlicherweise einen signifikanten Unterschied festzustellen, obwohl es keinen gibt). Übliche Signifikanzniveaus sind 0,05 (5%) und 0,01 (1%).

- Berechnen des P-Wertes: Führen Sie einen statistischen Test durch, z. B. einen t-Test oder einen Chi-Quadrat-Test, um den p-Wert zu berechnen. Der p-Wert gibt die Wahrscheinlichkeit an, mit der die von Ihnen ermittelten Ergebnisse zu beobachten sind, wenn es keine echten Unterschiede zwischen den Variationen gibt.

Beispiel: Wenn Ihr p-Wert 0,03 (3 %) beträgt, bedeutet dies, dass eine 3 %ige Wahrscheinlichkeit besteht, dass die beobachteten Unterschiede zufällig entstanden sind. - Vergleichen Sie den p-Wert mit dem Signifikanzniveau: Wenn der p-Wert kleiner oder gleich dem von Ihnen gewählten Signifikanzniveau (α), in der Regel 0,05, ist, gelten die Ergebnisse als statistisch signifikant. Dies deutet darauf hin, dass die Unterschiede zwischen den Varianten A und B wahrscheinlich nicht auf Zufall beruhen.

Beispiel: Wenn α = 0,05 und Ihr p-Wert 0,03 ist, sind die Ergebnisse statistisch signifikant. - Nicht-signifikante Ergebnisse: Wenn der p-Wert größer als α ist, sind die Ergebnisse nicht statistisch signifikant, was bedeutet, dass die beobachteten Unterschiede auf zufällige Variationen zurückzuführen sein könnten.

- Effektgröße: Betrachten Sie die Effektgröße, die die praktische Bedeutung der Unterschiede zwischen den Variationen misst. Eine kleine Effektgröße kann statistisch signifikant, aber praktisch nicht aussagekräftig sein.

- Stichprobengröße: Mit größeren Stichproben können kleinere Effekte festgestellt werden, und es ist wahrscheinlicher, dass sie statistisch signifikante Ergebnisse liefern.

Das Verständnis der statistischen Signifikanz ist von entscheidender Bedeutung, da es Ihnen hilft festzustellen, ob die Änderungen, die Sie in Variante B vorgenommen haben, eine echte Auswirkung hatten oder lediglich das Ergebnis eines Zufalls waren.

Interpretieren der Daten

Bei der Interpretation der Daten geht es darum, tiefer in die Zahlen einzudringen und die Implikationen Ihrer A/B-Test-Ergebnisse zu verstehen. Im Folgenden erfahren Sie, wie Sie bei der Dateninterpretation vorgehen:

- Konzentrieren Sie sich auf die wichtigsten Metriken: Beginnen Sie mit der Untersuchung der Schlüsselkennzahlen, die Sie in der Planungsphase ermittelt haben. Untersuchen Sie, wie sich diese zwischen den Varianten A und B verändert haben.

- Daten visualisieren: Erstellen Sie visuelle Darstellungen Ihrer Daten, z. B. Diagramme und Schaubilder, um Muster und Trends zu erkennen. Mit Hilfe von Visualisierungen lässt sich die Bedeutung der Unterschiede leichter erfassen.

- Daten segmentieren: Ziehen Sie in Erwägung, Ihre Daten nach verschiedenen Nutzereigenschaften oder Verhaltensweisen zu segmentieren. Dies kann Aufschluss darüber geben, wie bestimmte Gruppen auf die Variationen reagieren.

Beispiel: Wenn Sie einen A/B-Test für den elektronischen Handel durchführen, kann die Segmentierung nach Erstbesuchern und wiederkehrenden Kunden unterschiedliche Verhaltensmuster aufzeigen. - Zeitbasierte Analyse: Analysieren Sie die Daten im Zeitverlauf, um festzustellen, ob die Auswirkungen der Änderungen gleichbleibend sind oder sich im Laufe des Testzeitraums ändern.

- Vergleich mit den Zielsetzungen: Vergleichen Sie die Ergebnisse mit den klaren Zielen, die Sie zu Beginn des Tests festgelegt haben. Haben die Änderungen Ihren Zielen entsprochen?

- Qualitatives Feedback: Falls verfügbar, sammeln Sie qualitatives Feedback von den Nutzern, um Einblicke in ihre Präferenzen und die Gründe für ihre Handlungen zu erhalten.

- Berücksichtigen Sie die Benutzererfahrung: Konzentrieren Sie sich nicht nur auf quantitative Metriken. Beurteilen Sie, ob die Änderungen die allgemeine Benutzererfahrung verbessert oder verschlechtert haben.

- Suchen Sie nach unerwarteten Erkenntnissen: Manchmal können A/B-Tests unerwartete Erkenntnisse zutage fördern, die über Ihre ursprünglichen Ziele hinausgehen. Seien Sie offen für diese Entdeckungen.

Schlussfolgerungen ziehen

Das Ziehen von Schlussfolgerungen ist der letzte Schritt in Ihrer A/B-Testing-Reise, bei dem Sie Entscheidungen auf der Grundlage der Ergebnisse treffen:

- Identifizieren Sie die siegreiche Variante: Wenn die Ergebnisse statistisch signifikant sind und mit Ihren Zielen übereinstimmen, bestimmen Sie die siegreiche Variante (entweder A oder B).

- Praktische Bedeutung berücksichtigen: Berücksichtigen Sie die praktische Bedeutung der Änderungen. Selbst wenn die Ergebnisse statistisch signifikant sind, sollten Sie sich fragen, ob die beobachteten Unterschiede im Zusammenhang mit Ihren Zielen von Bedeutung sind.

- Dokumentieren Sie die gewonnenen Erkenntnisse: Dokumentieren Sie die aus dem A/B-Test gewonnenen Erkenntnisse, ob positiv oder negativ. Diese Erkenntnisse können in zukünftige Experimente und Optimierungsmaßnahmen einfließen.

- Änderungen umsetzen: Wenn Variante B der Gewinner ist und die Änderungen als praktisch bedeutsam erachtet werden, implementieren Sie die Änderungen an Ihrer Website, App oder Marketingkampagne.

- Kontinuierliche Verbesserung: Denken Sie daran, dass A/B-Tests ein iterativer Prozess sind. Testen und optimieren Sie weiter, um kontinuierliche Verbesserungen zu erzielen.

- Einblicke teilen: Teilen Sie die Ergebnisse und Erkenntnisse mit Ihrem Team oder Ihren Stakeholdern und fördern Sie so eine datengesteuerte Kultur in Ihrem Unternehmen.

Indem Sie die Ergebnisse analysieren, die Daten effektiv interpretieren und aussagekräftige Schlussfolgerungen ziehen, können Sie sicherstellen, dass Ihre A/B-Tests zu fundierten Entscheidungen und einer kontinuierlichen Verbesserung Ihrer digitalen Ressourcen führen.

Wie implementiert man Änderungen bei A/B-Tests?

Nachdem Sie Ihre A/B-Tests erfolgreich durchgeführt und die Ergebnisse analysiert haben, ist es an der Zeit, die Änderungen zu implementieren, mit denen Sie Ihre digitalen Inhalte optimieren können. Lassen Sie uns den Prozess der Auswahl der erfolgreichen Variante, der Skalierung erfolgreicher Änderungen und der Dokumentation Ihrer Erkenntnisse für zukünftige Referenzen durchgehen.

1. Die beste Variante wählen

Die Auswahl der besten Variante ist ein entscheidender Schritt im A/B-Testprozess. Hier erfahren Sie, wie Sie eine fundierte Entscheidung treffen:

- Berücksichtigen Sie die Zielsetzungen: Überdenken Sie die klaren Ziele, die Sie zu Beginn des A/B-Tests festgelegt haben. Wählen Sie die Variante, die am besten zu diesen Zielen passt.

- Statistische Signifikanz: Vergewissern Sie sich, dass die gewählte Variante statistisch signifikant ist und die andere(n) Variante(n) in Bezug auf die Schlüsselkennzahlen übertrifft.

- Praktische Signifikanz: Neben der statistischen Signifikanz muss auch die praktische Bedeutung der Veränderungen berücksichtigt werden. Fragen Sie sich, ob die beobachteten Verbesserungen für Ihr Unternehmen oder Projekt von Bedeutung sind.

- Benutzerfreundlichkeit: Beurteilen Sie, wie sich die Änderungen auf die allgemeine Benutzererfahrung auswirken. Entscheiden Sie sich für die Variante, die nicht nur Ihre Ziele erfüllt, sondern auch eine bessere Benutzererfahrung bietet.

- Langfristige Auswirkungen: Denken Sie an die langfristigen Auswirkungen Ihrer Entscheidung. Überlegen Sie, ob die Änderungen nachhaltig sein können und ob sie mit Ihrer übergeordneten Strategie übereinstimmen.

- Ausrichtung auf die Interessengruppen: Stellen Sie sicher, dass Ihre Entscheidung mit allen Beteiligten, einschließlich Teammitgliedern, Managern und Kunden, kommuniziert und abgestimmt wird.

- Feedback-Schleife: Holen Sie, wenn möglich, Feedback von Benutzern oder Kunden zu den Änderungen ein. Dies kann wertvolle Erkenntnisse über deren Präferenzen und Zufriedenheit liefern.

- Strenge der Tests: Denken Sie über die Strenge Ihres Testprozesses nach. Vergewissern Sie sich, dass der Test ordnungsgemäß und ohne Fehler oder Verzerrungen durchgeführt wurde und dass die Ergebnisse zuverlässig sind.

Wenn Sie diese Faktoren sorgfältig berücksichtigen, können Sie sich getrost für die beste Variante entscheiden, die zu den gewünschten Verbesserungen bei Ihren digitalen Assets führt.

2. Erfolgreiche Änderungen skalieren

Die Skalierung erfolgreicher Änderungen beinhaltet die Anwendung der aus Ihrem A/B-Test gewonnenen Erkenntnisse auf andere Bereiche Ihrer digitalen Präsenz, um eine breitere Wirkung zu erzielen. Hier erfahren Sie, wie Sie dies effektiv tun können:

- Replizieren Sie die Änderungen: Implementieren Sie die Änderungen der siegreichen Variante in einem größeren Maßstab. Dies kann die Aktualisierung mehrerer Seiten, Abschnitte oder Kampagnen beinhalten, die von den Verbesserungen profitieren können.

- Konsistenz: Stellen Sie sicher, dass die Änderungen in allen relevanten Bereichen mit Ihrer Markenidentität und Ihrem Messaging übereinstimmen.

- Iteration testen: Testen und optimieren Sie weiter, während Sie die erfolgreichen Änderungen skalieren. A/B-Tests sind ein fortlaufender Prozess, und es kann sein, dass weitere Verfeinerungen vorgenommen werden müssen.

- Prozesse dokumentieren: Dokumentieren Sie die Prozesse und Richtlinien für die Umsetzung erfolgreicher Änderungen. Auf diese Weise können Sie die Konsistenz wahren und sicherstellen, dass künftige Aktualisierungen mit den gewonnenen Erkenntnissen übereinstimmen.

- Kollaboration: Arbeiten Sie mit funktionsübergreifenden Teams zusammen, einschließlich Design, Entwicklung und Marketing, um eine koordinierte Umsetzung der Änderungen zu gewährleisten.

- Leistung überwachen: Behalten Sie die Leistung der skalierten Änderungen genau im Auge. Überwachen Sie die wichtigsten Metriken, um zu bestätigen, dass die im A/B-Test beobachteten Verbesserungen im Laufe der Zeit aufrechterhalten werden.

- Feedback-Schleife: Führen Sie eine Feedbackschleife mit den Nutzern oder Kunden, um Erkenntnisse zu sammeln und bei Bedarf iterative Verbesserungen vorzunehmen.

Die Skalierung erfolgreicher Änderungen maximiert nicht nur die Wirkung Ihrer A/B-Tests, sondern fördert auch eine Kultur der kontinuierlichen Verbesserung innerhalb Ihrer Organisation.

3. Dokumentieren Sie die Erkenntnisse

Die Dokumentation Ihrer A/B-Test-Erfahrungen ist für die kontinuierliche Optimierung und den Wissensaustausch unerlässlich. Hier erfahren Sie, wie Sie diese Erkenntnisse effektiv erfassen und nutzen können:

- Erstellen Sie ein Wissensrepository: Richten Sie ein zentrales Repository oder Dokument ein, in dem Sie die Details Ihrer A/B-Tests aufzeichnen können, einschließlich der Ziele, Varianten, Ergebnisse und Schlussfolgerungen.

- Einblicke einbeziehen: Dokumentieren Sie die aus jedem A/B-Test gewonnenen Erkenntnisse, sowohl die positiven als auch die negativen. Beschreiben Sie, was funktioniert hat, was nicht funktioniert hat und warum.

- Daten und Metriken: Fügen Sie für jeden Test relevante Daten und Metriken sowie Überlegungen zur statistischen Signifikanz und praktischen Bedeutung hinzu.

- Anschauungsmaterial und Beispiele: Verwenden Sie Grafiken, Screenshots und Beispiele, um die Änderungen und Ergebnisse zu veranschaulichen, damit sie für die Teammitglieder leichter verständlich sind.

- Weitergabe an Stakeholder: Geben Sie Ihre A/B-Testdokumentation an relevante Stakeholder weiter, z. B. Produktmanager, Designer, Entwickler und Marketingfachleute, um den Wissensaustausch zu erleichtern.

- Verwendung für zukünftige Tests: Nutzen Sie Ihre dokumentierten Erkenntnisse als Referenz für zukünftige A/B-Tests. Die Ergebnisse aus der Vergangenheit können als Grundlage für Ihre Testhypothesen und -strategien dienen.

- Kontinuierliche Überprüfung: Überprüfen und aktualisieren Sie Ihre Dokumentation regelmäßig, wenn neue Erkenntnisse und Testergebnisse verfügbar werden. So bleibt Ihr Wissen immer auf dem neuesten Stand.

- Schulung und Onboarding: Nutzen Sie Ihre Dokumentation, um neue Teammitglieder zu schulen und sie in Ihren A/B-Testprozess und Ihre bewährten Verfahren einzuführen.

Indem Sie Ihre A/B-Test-Erfahrungen systematisch dokumentieren, schaffen Sie eine wertvolle Ressource, die datengestützte Entscheidungen unterstützt, die Zusammenarbeit fördert und die kontinuierliche Verbesserung Ihrer digitalen Projekte erleichtert.

A/B-Testing-Tools

A/B-Tests sind eine leistungsstarke Methode zur Optimierung digitaler Assets, aber sie sind nur so effektiv wie die Tools, die Sie zur Durchführung und Analyse Ihrer Tests verwenden. Es gibt eine Vielzahl von A/B-Testing-Tools, die Ihnen helfen, den Prozess zu rationalisieren und aussagekräftige Erkenntnisse zu gewinnen. Wir gehen auf die Aspekte dieser Tools ein und erläutern, worauf Sie bei der Auswahl eines Tools achten sollten, ohne dabei bestimmte Tools (außer Appinio) zu nennen.

Was A/B-Testing-Tools bieten

A/B-Testing-Tools bieten eine Reihe von Merkmalen und Funktionen zur Unterstützung Ihres Experimentierprozesses. Hier sind einige gemeinsame Elemente, die Sie von solchen Tools erwarten können:

- Erstellung von Variationen: Die meisten A/B-Testing-Tools bieten einfach zu bedienende Schnittstellen für die Erstellung und Verwaltung verschiedener Varianten Ihrer digitalen Assets.

- Randomisierung: Sie stellen sicher, dass die Nutzer den Variationen nach dem Zufallsprinzip zugewiesen werden, um Verzerrungen zu vermeiden und die Fairness im Testprozess zu wahren.

- Statistische Analyse: A/B-Testing-Tools verfügen in der Regel über integrierte statistische Analysefunktionen, um die Signifikanz der Ergebnisse zu ermitteln.

- Konversionsverfolgung: Mit diesen Tools können Sie Konversionen und wichtige Kennzahlen genau nachverfolgen und so die Auswirkungen von Änderungen bewerten.

- Segmentierung: Viele Tools ermöglichen es Ihnen, Ihr Publikum nach verschiedenen Kriterien zu segmentieren, so dass Sie Erkenntnisse darüber gewinnen können, wie verschiedene Benutzergruppen auf Variationen reagieren.

- Visualisierungen: Visuelle Darstellungen von Daten, wie Diagramme und Grafiken, helfen Ihnen, die Auswirkungen von Änderungen schnell zu verstehen.

- Datenexport: Der Export von Rohdaten und Ergebnissen ist für eine eingehende Analyse und Dokumentation unerlässlich.

Was ist bei der Auswahl eines A/B-Test-Tools zu beachten?

Die Auswahl des richtigen A/B-Testing-Tools ist entscheidend für den Erfolg Ihrer Experimente. Im Folgenden finden Sie einige Faktoren, die Sie bei Ihrer Wahl berücksichtigen sollten:

- Benutzerfreundlichkeit: Suchen Sie nach einem Tool mit einer intuitiven Benutzeroberfläche, mit der Ihr Team auch ohne tiefgreifende technische Kenntnisse leicht zurechtkommt.

- Statistische Strenge: Stellen Sie sicher, dass das Tool eine zuverlässige statistische Analyse bietet, um die Signifikanz Ihrer Ergebnisse genau zu bestimmen.

- Integration: Achten Sie darauf, ob sich das Tool nahtlos in Ihr bestehendes technisches System integrieren lässt, einschließlich Analyseplattformen und Marketing-Tools.

- Zielgruppenansprache: Wenn Ihre Zielgruppe sehr unterschiedlich ist, sollten Sie ein Tool wählen, das eine genaue Segmentierung der Zielgruppe ermöglicht.

- Budget: A/B-Testing-Tools werden mit unterschiedlichen Preisstrukturen angeboten. Prüfen Sie, ob die Kosten des Tools mit Ihrem Budget und dem erwarteten ROI übereinstimmen.

- Support und Schulung: Prüfen Sie, ob das Tool Kundenunterstützung, Schulungsressourcen und Dokumentation bietet, damit Sie das Tool optimal nutzen können.

Denken Sie daran, dass die Wahl eines A/B-Test-Tools auf Ihre spezifischen Bedürfnisse und Ziele abgestimmt sein sollte. Es gibt zwar viele Tools, aber jedes bietet einzigartige Funktionen und Möglichkeiten. Das richtige Tool kann Ihren A/B-Testing-Prozess effizienter und aufschlussreicher machen, was letztendlich zu datengesteuerten Verbesserungen Ihrer digitalen Assets führt.

Appinio ist eine hervorragende Plattform für die Gewinnung von Echtzeit-Konsumenteneinblicken, die Ihre A/B-Testing-Bemühungen ergänzen können, indem sie wertvolles Feedback und Input direkt von Ihrer Zielgruppe liefern.

Beispiele für A/B-Tests

Um ein besseres Verständnis für die Funktionsweise von A/B-Tests in der Praxis zu erlangen, sollten wir uns einige Beispiele aus der Praxis ansehen, die von Unternehmen und Organisationen aus verschiedenen Branchen durchgeführt wurden:

E-Commerce: Testen des Layouts einer Produktseite

Szenario: Ein E-Commerce-Unternehmen möchte das Layout seiner Produktseite optimieren, um Konversionen und Verkäufe zu steigern.

A/B-Test: Das Unternehmen erstellt zwei Varianten seiner Produktseite:

- Version A: Die Kontrollgruppe mit dem bestehenden Layout der Produktseite.

- Version B: Die Versuchsgruppe mit einem neu gestalteten Layout, das die Produktbewertungen hervorhebt und eine prominente Call-to-Action-Schaltfläche enthält.

Zielsetzung: Erhöhung der Click-Through-Rate (CTR) auf die Schaltfläche "In den Warenkorb" und damit Steigerung des Umsatzes.

Ergebnisse: Nach Durchführung des A/B-Tests zeigt Version B einen statistisch signifikanten Anstieg der CTR um 20 % im Vergleich zu Version A. Die Nutzer empfanden das neue Layout als ansprechender und konversionsfreundlicher, was zu einer erheblichen Umsatzsteigerung führte.

Inhaltliches Marketing: Schlagzeilen testen

Szenario: Eine Nachrichten-Website möchte das Engagement der Nutzer und die Klickraten für ihre Artikel verbessern.

A/B-Test: Die Nachrichten-Website führt einen A/B-Test für Artikelüberschriften durch:

- Version A: Enthält die ursprünglichen Schlagzeilen.

- Version B: Es werden neue, aufmerksamkeitsstarke Überschriften verwendet.

Zielsetzung: Erhöhung der Klickrate (CTR) auf Artikellinks und Ermutigung von mehr Lesern, den Inhalt zu erkunden.

Ergebnisse: Version B übertrifft Version A und zeigt eine statistisch signifikante Steigerung der CTR um 15 %. Die ansprechenden Überschriften verleiten mehr Leser dazu, auf Artikel zu klicken, was zu höheren Seitenaufrufen und längeren Sitzungsdauern führt.

E-Mail-Marketing: Testen von Betreffzeilen

Szenario: Ein E-Mail-Marketingteam möchte die Öffnungs- und Klickraten seiner Newsletter verbessern.

A/B-Test: Das Team führt einen A/B-Test für E-Mail-Betreffzeilen durch:

- Version A: Enthält die ursprünglichen Betreffzeilen.

- Version B: Verwendet neue, prägnante und personalisierte Betreffzeilen.

Zielsetzung: Erhöhung der Öffnungsrate und Klickrate (CTR) von E-Mail-Newslettern, um mehr Besucher auf die Website zu bringen.

Ergebnisse: Version B erreicht eine statistisch signifikante Steigerung der Öffnungsrate um 10 % und der CTR um 12 % im Vergleich zu Version A. Die personalisierten und prägnanten Betreffzeilen ziehen die Aufmerksamkeit der Abonnenten stärker auf sich.

Software: Testen der Funktionsübernahme

Szenario: Ein Softwareunternehmen möchte mit einer neuen Funktion in seiner Anwendung die Benutzerakzeptanz verbessern.

A/B-Test: Das Unternehmen führt einen A/B-Test für die Einführung der neuen Funktion durch:

- Version A: Bietet ein kurzes Tutorial, wenn der Nutzer das erste Mal auf die neue Funktion stößt.

- Version B: Bietet Tooltips und In-App-Anleitungen für die Nutzer, während sie die Funktion erkunden.

Zielsetzung: Erhöhung der Benutzerakzeptanz und des Engagements für die neue Funktion.

Ergebnisse: Version B zeigt einen statistisch signifikanten Anstieg der Akzeptanz der Funktion um 25 % im Vergleich zu Version A. Die Nutzer empfinden die In-App-Anleitung als hilfreicher, was zu einer verstärkten Nutzung der neuen Funktion führt.

Diese Beispiele verdeutlichen die Vielseitigkeit von A/B-Tests in verschiedenen Bereichen. Ganz gleich, ob Sie E-Commerce-Websites, Content-Marketing-Strategien, E-Mail-Kampagnen oder Softwarefunktionen optimieren, mit A/B-Tests können Sie datengestützte Entscheidungen treffen und das Nutzererlebnis und die Geschäftsergebnisse kontinuierlich verbessern. Denken Sie daran, dass die spezifischen Variablen, Ziele und Messgrößen je nach den individuellen Zielen der einzelnen A/B-Tests variieren.

Bewährte Praktiken für A/B-Tests

A/B-Tests sind ein leistungsfähiges Instrument, aber Sie müssen sich an bewährte Verfahren halten, um es optimal nutzen zu können. Diese Praktiken gewährleisten, dass Ihre Tests genau und zuverlässig sind und verwertbare Erkenntnisse liefern. Im Folgenden finden Sie einige wichtige Tipps für A/B-Tests, die Sie beachten sollten:

- Testen Sie eine Variable nach der anderen: Konzentrieren Sie sich bei der Erstellung von Variationen darauf, jeweils eine Variable zu ändern. Dadurch lassen sich die Auswirkungen der Änderung isolieren und die Ergebnisse leichter nachvollziehen. Wenn Sie mehrere Elemente gleichzeitig ändern, können Sie nicht feststellen, welches Element das Ergebnis beeinflusst hat.

- Setzen Sie sich klare Ziele: Definieren Sie klare, spezifische und messbare Ziele für Ihre A/B-Tests. Ohne klare Ziele laufen Sie Gefahr, Tests durchzuführen, die keine verwertbaren Erkenntnisse liefern oder nicht mit Ihren übergeordneten Zielen übereinstimmen.

- Randomisierung und Kontrollgruppen: Vergewissern Sie sich, dass Sie die Besucher nach dem Zufallsprinzip den Varianten zuordnen und immer eine Kontrollgruppe (Version A) einschließen, die unverändert bleibt. Auf diese Weise werden Verzerrungen minimiert und eine Basis für Vergleiche geschaffen.

- Ausreichende Stichprobengröße: Berechnen und verwenden Sie eine angemessene Stichprobengröße, um statistische Signifikanz zu gewährleisten. Kleinere Stichproben können zu unzuverlässigen Ergebnissen führen, während größere Stichproben eher dazu geeignet sind, kleinere Effekte zu erkennen.

- Statistische Signifikanz: Verstehen Sie das Konzept der statistischen Signifikanz und wählen Sie ein Signifikanzniveau (Alpha), bevor Sie Tests durchführen. Ziehen Sie nur Schlussfolgerungen aus Ergebnissen, die statistische Signifikanz erreichen.

- Berücksichtigen Sie die praktische Signifikanz: Auch wenn die statistische Signifikanz von entscheidender Bedeutung ist, sollten Sie auch die praktische Bedeutung von Veränderungen bewerten. Stellen Sie sich die Frage, ob die beobachteten Unterschiede aussagekräftig sind und einen spürbaren Einfluss auf Ihre Ziele haben.

- Vermeiden Sie Verzerrungen: Achten Sie auf die Vermeidung von Verzerrungen, sowohl bei der Durchführung Ihrer Tests als auch bei der Interpretation der Ergebnisse. Selektionsverzerrungen, Bestätigungsverzerrungen und andere Verzerrungen können zu irreführenden Schlussfolgerungen führen.

- Segmentieren Sie Ihre Daten: Segmentieren Sie Ihre Daten nach demografischen Merkmalen, Verhalten oder anderen relevanten Faktoren, um Erkenntnisse darüber zu gewinnen, wie verschiedene Benutzergruppen auf Variationen reagieren. Auf diese Weise können Sie wertvolle Erkenntnisse gewinnen, die in den aggregierten Daten möglicherweise nicht sichtbar sind.

- Kontinuierliche Tests und Iteration: A/B-Tests sind ein fortlaufender Prozess. Testen und optimieren Sie Ihre digitalen Ressourcen kontinuierlich, um mit den sich ändernden Nutzerpräferenzen und Markttrends Schritt zu halten. Überprüfen und aktualisieren Sie Ihre Tests und Varianten regelmäßig.

- Dokumentieren Sie alles: Führen Sie detaillierte Aufzeichnungen über Ihre A/B-Tests, einschließlich der Ziele, Varianten, Ergebnisse und Schlussfolgerungen. Die Dokumentation stellt sicher, dass Sie aus vergangenen Tests lernen und Erkenntnisse mit Ihrem Team teilen können.

- Änderungen umgehend umsetzen: Sobald Sie eine erfolgreiche Variante ermittelt haben, sollten Sie die Änderungen umgehend umsetzen. Verzögerungen bei der Umsetzung können dazu führen, dass Sie Chancen zur Verbesserung verpassen.

- Benutzer-Feedback: Beziehen Sie das Feedback der Benutzer in Ihren Testprozess ein. Sammeln Sie qualitative Erkenntnisse von den Nutzern, um ein tieferes Verständnis für ihre Präferenzen und Motivationen zu gewinnen.

- Datenschutz und Compliance: Halten Sie sich bei der Erfassung und Verarbeitung von Nutzerdaten an Datenschutzbestimmungen wie GDPR oder CCPA. Stellen Sie sicher, dass Ihre Testprozesse den einschlägigen Gesetzen und Vorschriften entsprechen.

- Bilden Sie Ihr Team aus: Klären Sie Ihre Teammitglieder über die besten Praktiken und Prinzipien von A/B-Tests auf. Fördern Sie eine datengesteuerte Kultur in Ihrem Unternehmen, in der Entscheidungen auf Beweisen und nicht auf Annahmen beruhen.

- Geben Sie Ergebnisse und Einblicke weiter: Teilen Sie die Ergebnisse und Erkenntnisse aus Ihren A/B-Tests mit den relevanten Interessengruppen. Transparenz und Kommunikation helfen dabei, Teams aufeinander abzustimmen und die Zusammenarbeit zu fördern.

Wenn Sie sich an diese Best Practices für A/B-Tests halten, können Sie die Effektivität Ihrer Tests maximieren, fundierte Entscheidungen treffen und Ihre digitalen Assets kontinuierlich verbessern, um Ihre Ziele und Benutzeranforderungen besser zu erfüllen.

Fazit zu A/B-Tests

A/B-Tests sind Ihr Schlüssel, um das Potenzial der datengesteuerten Optimierung zu erschließen. Durch die Durchführung systematischer Experimente und die Analyse der Ergebnisse können Sie fundierte Entscheidungen treffen, die Benutzererfahrung verbessern und bessere Ergebnisse in der digitalen Welt erzielen. Denken Sie daran, dass die Reise der kontinuierlichen Verbesserung durch A/B-Tests nie zu Ende ist; es ist ein Weg zu kontinuierlichem Erfolg in der sich ständig weiterentwickelnden Online-Landschaft.

Denken Sie bei der Durchführung von A/B-Tests daran, dass der Erfolg auf einer Kombination aus klaren Zielen, sorgfältiger Planung, unvoreingenommenen Tests und sorgfältiger Analyse beruht. Wenn Sie sich an bewährte Verfahren halten, agil bleiben und die aus jedem Test gewonnenen Erkenntnisse nutzen, sind Sie auf dem besten Weg, Ihre digitalen Ziele zu erreichen und der Konkurrenz einen Schritt voraus zu sein.

Wie führt man A/B-Tests in wenigen Minuten durch?

Stellen Sie sich vor, Sie könnten A/B-Tests blitzschnell durchführen, innerhalb von Minuten Erkenntnisse über die Verbraucher gewinnen und mühelos datengesteuerte Entscheidungen treffen. Das ist die Leistung von Appinio, der Echtzeit-Marktforschungsplattform, die das Spiel neu definiert. Hier erfahren Sie, warum Sie Appinio für Ihre A/B-Tests in Betracht ziehen sollten:

- Schnelle Einblicke: Die Plattform von Appinio liefert Antworten innerhalb von Minuten und ermöglicht es Ihnen, schnelle Entscheidungen auf der Grundlage von Verbraucherfeedback in Echtzeit zu treffen.

- Benutzerfreundlich: Sie brauchen keinen Doktortitel in Forschung. Die intuitive Benutzeroberfläche von Appinio ermöglicht es jedem, A/B-Tests mit Leichtigkeit durchzuführen.

- Globale Reichweite: Definieren Sie Ihre Zielgruppe aus mehr als 1.200 Merkmalen und befragen Sie Verbraucher in über 90 Ländern, um sicherzustellen, dass Ihre Tests wirklich repräsentativ sind.

Fakten, die im Kopf bleiben 🧠

Interessiert an weiteren Insights? Dann sind unsere Reports genau das richtige, mit Trends und Erkenntnissen zu allen möglichen Themen.